简单分析一下主流的几种神经网络

LeNet

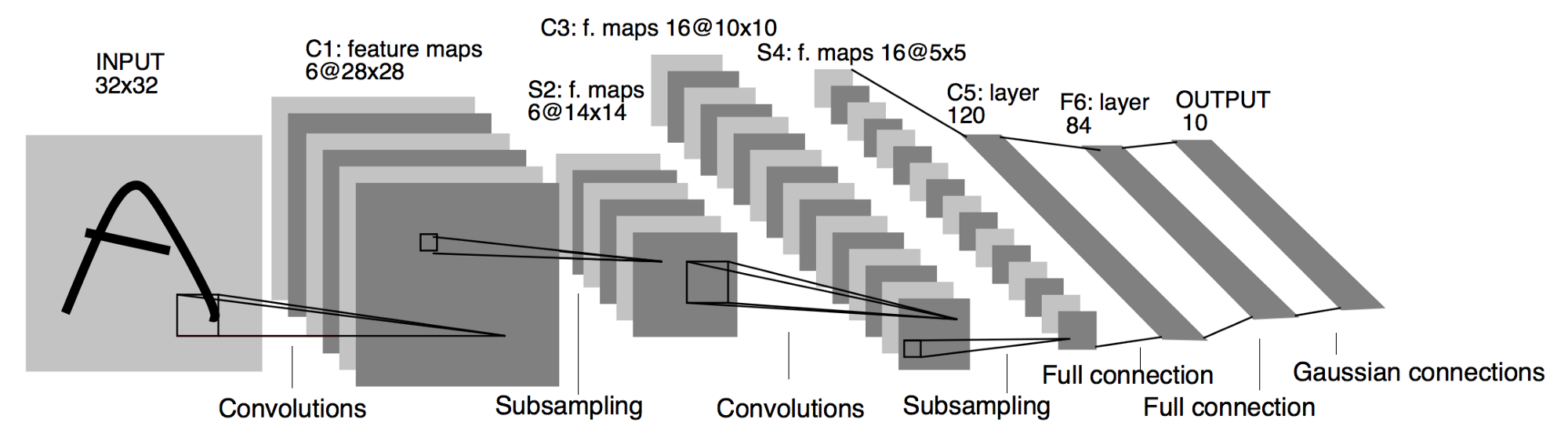

LetNet作为卷积神经网络中的HelloWorld,它的结构及其的简单,1998年由LeCun提出

基本过程:

可以看到LeNet-5跟现有的conv->pool->ReLU的套路不同,它使用的方式是conv1->pool->conv2->pool2再接全连接层,但是不变的是,卷积层后紧接池化层的模式依旧不变。

代码:

import torch.nn as nn |

输出

tensor([[ 0.0067, -0.0431, 0.1072, 0.1275, 0.0143, 0.0865, -0.0490, -0.0936, |

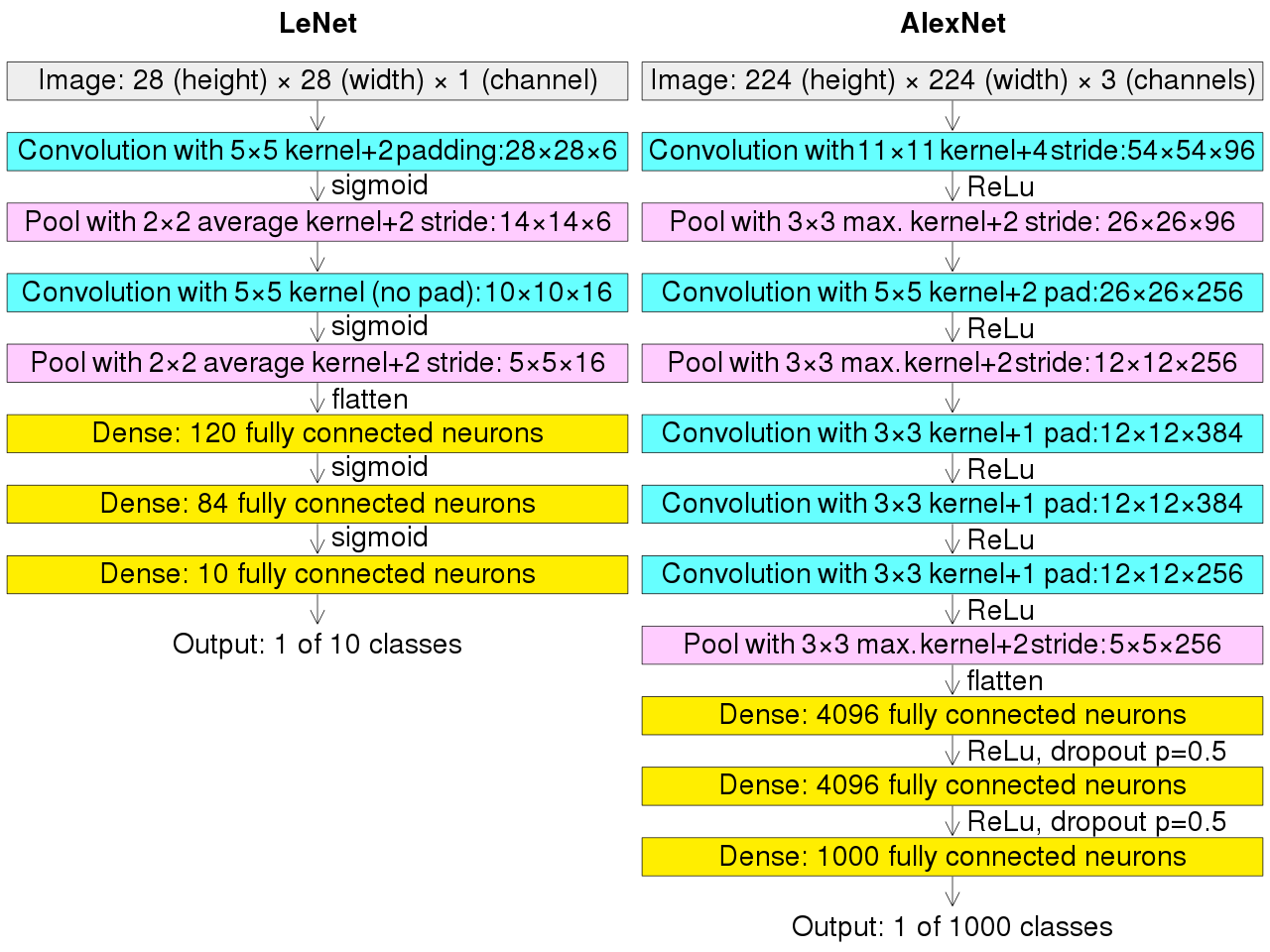

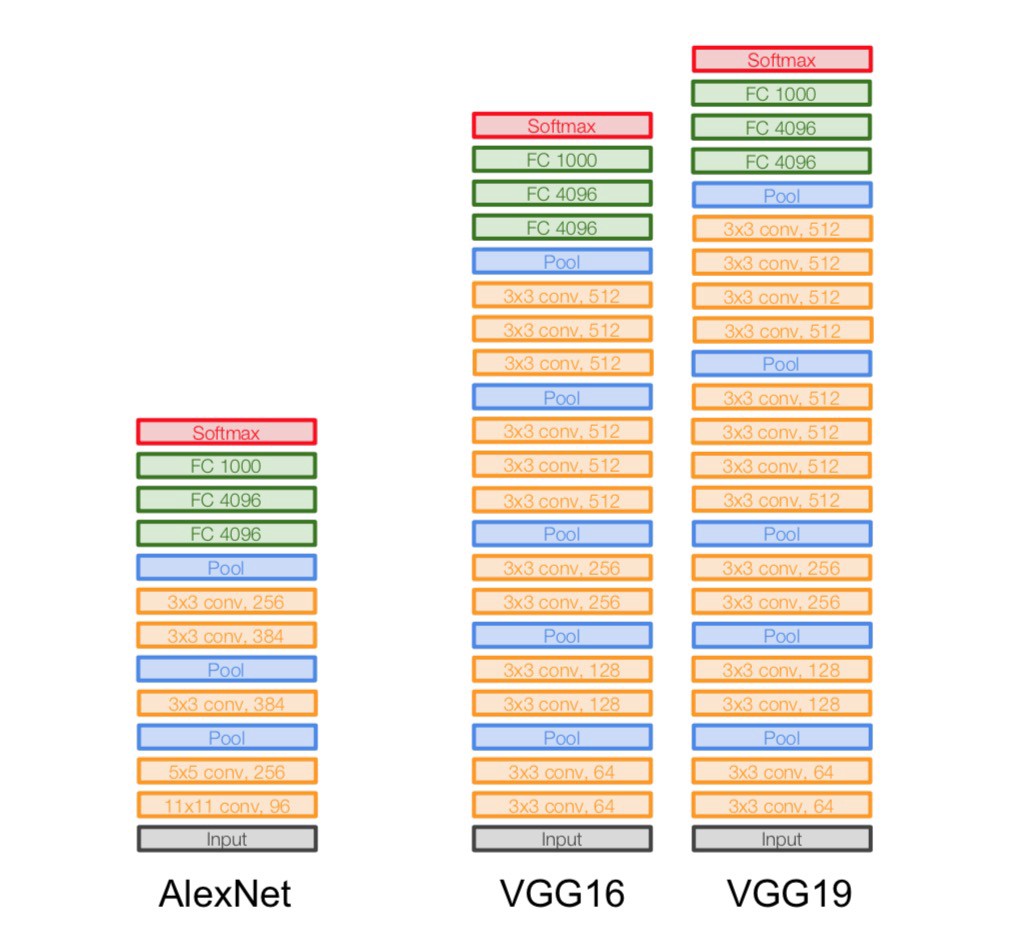

AlexNet

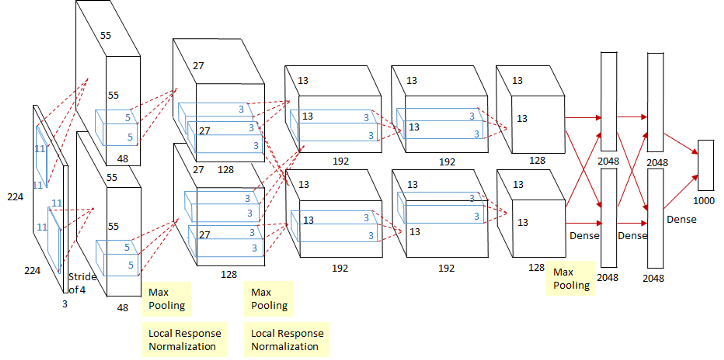

这个图看起来稍微可能有亿点复杂,其实这个是因为当时的GPU计算能力不太行,而Alex又比较复杂,所以Alex使用了两个GPU并行来做运算,现在已经完全可以用一个GPU来代替了。

相对于LeNet来说,Alex网络层数更深,同时第一次引入了激活层ReLU,又在全连接层引入了Dropout层防止过拟合。

执行流程图在上面,跟LeNet的执行流程图放在一张图上。

代码:

import torch.nn as nn |

输出:

torch.Size([1, 256, 5, 5]) |

VggNet

VggNet是ImageNet 2014年的亚军,总的来说就是它使用了更小的滤波器,用了更深的结构来提升深度学习的效果,从图里面可以看出来这一点,它没有使用11*11这么大的滤波器,取而代之的使用的都是3*3这种小的滤波器,它之所以使用很多小的滤波器,是因为层叠很多小的滤波器的感受野和一个大的滤波器的感受野是相同的,还能减少参数。

代码实现:

import torch.nn as nn |

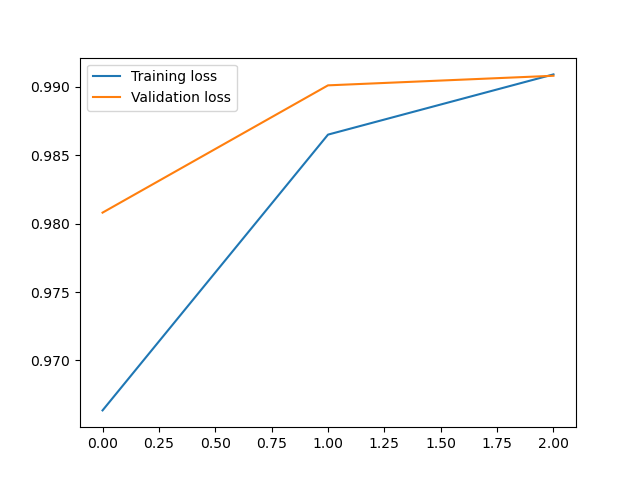

使用卷积神经网络实现对Minist数据集的预测

代码:

import matplotlib.pyplot as plt |

输出:

第0次训练:训练准确率:0.9646166666666718,测试准确率:0.9868999999999996 |